L’intelligenza artificiale generativa presenta una sfida filosofica e pratica su una scala mai sperimentata dall’inizio dell’Illuminismo.

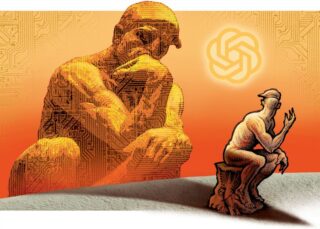

Una nuova tecnologia si propone di trasformare il processo cognitivo umano poiché non è stato scosso dall’invenzione della stampa. La tecnologia che ha stampato la Bibbia di Gutenberg nel 1455 ha reso il pensiero umano astratto comunicabile in modo generale e rapido. Ma la nuova tecnologia oggi inverte quel processo. Mentre la stampa ha prodotto una profusione del pensiero umano moderno, la nuova tecnologia raggiunge la sua distillazione ed elaborazione. Nel processo, crea un divario tra la conoscenza umana e la comprensione umana. Se vogliamo navigare con successo in questa trasformazione, sarà necessario sviluppare nuovi concetti di pensiero umano e interazione con le macchine. Questa è la sfida essenziale dell’era dell’intelligenza artificiale.

La nuova tecnologia è nota come intelligenza artificiale generativa; GPT è l’acronimo di Generative Pre-Trained Transformer. ChatGPT, sviluppato presso il laboratorio di ricerca OpenAI, è ora in grado di conversare con gli umani. Man mano che le sue capacità si ampliano, ridefiniranno la conoscenza umana, accelereranno i cambiamenti nel tessuto della nostra realtà e riorganizzeranno la politica e la società.

L’intelligenza artificiale generativa presenta una sfida filosofica e pratica su una scala mai sperimentata dall’inizio dell’Illuminismo. La stampa ha consentito agli studiosi di replicare rapidamente le scoperte degli altri e condividerle. Un consolidamento e una diffusione senza precedenti delle informazioni ha generato il metodo scientifico. Ciò che era stato impenetrabile divenne il punto di partenza di un’interrogazione accelerata. L’interpretazione medievale del mondo basata sulla fede religiosa è stata progressivamente minata. Le profondità dell’universo potevano essere esplorate fino a raggiungere nuovi limiti della comprensione umana.

L’intelligenza artificiale generativa presenta una sfida filosofica e pratica su una scala mai sperimentata dall’inizio dell’Illuminismo. La stampa ha consentito agli studiosi di replicare rapidamente le scoperte degli altri e condividerle. Un consolidamento e una diffusione senza precedenti delle informazioni ha generato il metodo scientifico. Ciò che era stato impenetrabile divenne il punto di partenza di un’interrogazione accelerata. L’interpretazione medievale del mondo basata sulla fede religiosa è stata progressivamente minata. Le profondità dell’universo potevano essere esplorate fino a raggiungere nuovi limiti della comprensione umana.

Allo stesso modo, l’IA generativa aprirà strade rivoluzionarie per la ragione umana e nuovi orizzonti per la conoscenza consolidata. Ma ci sono differenze categoriche. La conoscenza dell’illuminazione è stata raggiunta progressivamente, passo dopo passo, con ogni passo verificabile e insegnabile. I sistemi abilitati all’intelligenza artificiale iniziano dall’altra parte. Possono archiviare e distillare un’enorme quantità di informazioni esistenti, nel caso di ChatGPT gran parte del materiale testuale su Internet e un gran numero di libri, miliardi di articoli. Tenere quel volume di informazioni e distillarlo è al di là delle capacità umane.

Sofisticati metodi di intelligenza artificiale producono risultati senza spiegare perché o come funziona il loro processo. Il computer GPT riceve una richiesta da un essere umano. La macchina di apprendimento risponde in un testo letterale in pochi secondi. È in grado di farlo perché dispone di rappresentazioni pregenerate dei vasti dati su cui è stato addestrato. Poiché il processo con cui ha creato quelle rappresentazioni è stato sviluppato dall’apprendimento automatico che riflette modelli e connessioni su vaste quantità di testo, le fonti precise e le ragioni per le caratteristiche particolari di ciascuna rappresentazione rimangono sconosciute. Con quale processo la macchina che apprende memorizza la sua conoscenza, la distilla e la recupera rimane allo stesso modo sconosciuto. Se quel processo verrà mai scoperto, il mistero associato all’apprendimento automatico sfiderà la cognizione umana per un futuro indefinito.

Le capacità dell’IA non sono statiche, ma si espandono in modo esponenziale man mano che la tecnologia avanza. Di recente, la complessità dei modelli di intelligenza artificiale è raddoppiata ogni pochi mesi. Pertanto i sistemi di intelligenza artificiale generativa hanno capacità che rimangono nascoste anche ai loro inventori. Con ogni nuovo sistema di intelligenza artificiale, stanno costruendo nuove capacità senza comprenderne l’origine o la destinazione. Di conseguenza, il nostro futuro contiene ora un elemento completamente nuovo di mistero, rischio e sorpresa.

La scienza illuminista ha accumulato certezze; la nuova IA genera ambiguità cumulative. La scienza dell’illuminismo si è evoluta rendendo i misteri spiegabili, delineando i confini della conoscenza e della comprensione umana mentre si muovevano. Le due facoltà si muovevano di pari passo: Ipotesi era comprensione pronta a diventare conoscenza; l’induzione era la conoscenza che si trasformava in comprensione. Nell’era dell’intelligenza artificiale, gli enigmi vengono risolti da processi che rimangono sconosciuti. Questo paradosso disorientante rende i misteri non misteriosi ma anche inspiegabili. Intrinsecamente, l’intelligenza artificiale altamente complessa promuove la conoscenza umana ma non la comprensione umana, un fenomeno contrario a quasi tutta la modernità post-illuminista. Tuttavia, allo stesso tempo, l’intelligenza artificiale, se abbinata alla ragione umana, rappresenta un mezzo di scoperta più potente della sola ragione umana.

La differenza essenziale tra l’Età dell’Illuminismo e l’Età dell’IA non è quindi tecnologica ma cognitiva. Dopo l’Illuminismo, la filosofia ha accompagnato la scienza. Nuovi dati sconcertanti e spesso contrari, conclusioni intuitive, dubbi e insicurezze sono stati dissipati da spiegazioni complete dell’esperienza umana. Allo stesso modo, l’IA generativa è pronta a generare una nuova forma di coscienza umana. Finora, tuttavia, l’opportunità esiste in colori per i quali non abbiamo spettro e in direzioni per le quali non abbiamo bussola. Nessuna leadership politica o filosofica si è formata per spiegare e guidare questa nuova relazione tra uomo e macchina, lasciando la società relativamente senza ormeggi.

ChatGPT è un esempio di ciò che è noto come modello di linguaggio di grandi dimensioni, che può essere utilizzato per generare testo simile a quello umano. GPT è un tipo di modello che può essere appreso automaticamente da grandi quantità di testo senza la necessità di supervisione umana. Gli sviluppatori di ChatGPT gli hanno fornito una quantità enorme di contenuti testuali del mondo digitale. La potenza di calcolo consente al modello di acquisire modelli e connessioni.

La capacità dei modelli linguistici di grandi dimensioni di generare un testo simile all’uomo è stata una scoperta quasi casuale. Questi modelli sono addestrati per essere in grado di prevedere la parola successiva in una frase, il che è utile in attività come il completamento automatico per l’invio di messaggi di testo o la ricerca sul Web. Ma si scopre che i modelli hanno anche la capacità inaspettata di creare paragrafi, articoli molto articolati e col tempo forse libri.

ChatGPT è ulteriormente specializzato oltre un modello linguistico di base di grandi dimensioni, utilizzando il feedback degli umani per mettere a punto il modello in modo che generi un testo conversazionale dall’aspetto più naturale, nonché per cercare di contenere la sua propensione a risposte inappropriate (una sfida sostanziale per i modelli di linguaggio di grandi dimensioni ). ChatGPT converte istantaneamente le sue rappresentazioni in risposte uniche. L’ultima impressione su un conversante umano è che l’IA stia mettendo in relazione raccolte fisse di fatti in concetti dinamici.

Le risposte, le dichiarazioni e le osservazioni di ChatGPT appaiono senza una spiegazione della loro provenienza e senza un autore identificabile. A prima vista, ChatGPT non ha motivi o pregiudizi distinguibili. I suoi risultati sono complessi, ma il suo lavoro è sorprendentemente rapido: in pochi secondi, può produrre risposte che spiegano in modo coerente un argomento di alto livello. Non vengono semplicemente copiati dal testo nella memoria del computer. Sono generati di nuovo da un processo che gli esseri umani non sono in grado di replicare. È in grado di incorporare ipotesi e inferenze psicologiche non ovvie.

Può stabilire la priorità tra miliardi di punti dati per selezionare il singolo set di 200 parole più rilevante (o che apparirà più rilevante per un lettore umano). Nelle sue stesse parole, esprime giudizi probabilistici sui risultati futuri, fondendo le informazioni provenienti da domini discreti in una risposta integrata. Sembra accettare punti di vista contrari, presentandoli come simultaneamente compatibili. Imita altra scrittura senza copiarla. Anche se il modello non è in grado di comprendere in senso umano, i suoi risultati riflettono un’essenza sottostante del linguaggio umano.

Abbiamo chiesto a ChatGPT di spiegare le sue capacità. Può prevedere il futuro?

No, ha risposto. “Posso solo fornire informazioni e rispondere a domande sulla base dei dati su cui sono stato addestrato. Non ho esperienze personali o coscienza, quindi non sono in grado di fare previsioni o previsioni su eventi futuri.

È in grado di formulare giudizi probabilistici?

“Posso fornire giudizi probabilistici basati sui dati su cui sono stato addestrato. Ad esempio, se sono stato addestrato su un ampio set di dati di modelli meteorologici, potrei essere in grado di fornire un giudizio probabilistico sulla probabilità che un particolare tipo di tempo si verifichi in un luogo specifico in un dato giorno. Tuttavia, è importante notare che questi giudizi probabilistici si basano su modelli e tendenze nei dati e potrebbero non riflettere sempre accuratamente i risultati del mondo reale.

Prompt: Scrivi un breve saggio nel pensiero di Henry Kissinger sul ruolo dell’intelligenza artificiale generale nel controllo internazionale degli armamenti.

La risposta iniziava: “Poiché ci troviamo sull’orlo di una nuova rivoluzione tecnologica, la questione dell’intelligenza artificiale generale e del suo ruolo nel controllo internazionale degli armamenti diventa sempre più pressante. L’AGI porterà una stabilità senza precedenti, poiché i sistemi avanzati assumeranno il controllo dei processi decisionali associati alla deterrenza nucleare? O introdurrà una nuova serie di pericoli, poiché l’equilibrio globale del potere viene alterato dallo sviluppo di macchine altamente intelligenti?

Abbiamo interrogato ChatGPT su argomenti di interesse immediato, come il ruolo della Russia nel mantenere o minare la stabilità europea. Ha dato risposte apparentemente ponderate e concise in meno di un minuto, bilanciando informazioni contraddittorie e rispondendo in modo completo senza dare l’impressione di avere un’opinione.

All’estremità ricevente, l’intelligenza artificiale generativa appare sovrumana o almeno notevolmente migliorata dal punto di vista cognitivo. All’utente ingenuo, sembra uno studioso-bibliotecario estremamente veloce e altamente articolato accoppiato con un sapiente professore. Facilita il riassunto e l’interrogazione della conoscenza del mondo in modo molto più efficace di qualsiasi interfaccia tecnologica o umana esistente, e lo fa con una completezza unica. La sua capacità di integrare più domini di conoscenza e imitare molteplici aspetti del pensiero umano lo rende poliedrico a un livello che supera le ambizioni di qualsiasi gruppo di umani di alto livello. Tutte queste qualità incoraggiano l’accettazione incondizionata di tutto ciò che GPT genera e una sorta di atmosfera magica per il loro funzionamento. Tuttavia, allo stesso tempo, possiede la capacità di disinformare i suoi utenti umani con dichiarazioni errate e vere e proprie invenzioni

Entro pochi giorni dal lancio di ChatGPT, più di un milione di persone si sono iscritte per porre domande. Centinaia di aziende stanno lavorando su tecnologie generative e gli investimenti si stanno riversando, inclinando le scoperte verso il campo commerciale. Gli enormi motivi commerciali, per il prossimo futuro, avranno la precedenza sul pensiero a lungo termine sulle loro implicazioni.

Il più grande di questi modelli è costoso da addestrare, a nord di $1 miliardo per modello. Una volta addestrati, migliaia di computer lavorano 24 ore al giorno per farli funzionare. Il funzionamento di un modello preaddestrato è economico rispetto all’addestramento stesso e richiede solo capitale, piuttosto che capitale e abilità informatiche. Tuttavia, il pagamento per l’uso esclusivo di un modello linguistico di grandi dimensioni rimane al di fuori dei limiti della maggior parte delle imprese. È probabile che gli sviluppatori di questi modelli vendano abbonamenti, in modo che un singolo modello soddisfi le esigenze di molte migliaia di individui e aziende. Di conseguenza, il numero di modelli linguistici molto ampi nel prossimo decennio potrebbe essere relativamente limitato. La progettazione e il controllo di questi modelli saranno altamente concentrati, anche se il loro potere di amplificare gli sforzi e il pensiero umani diventerà molto più diffuso.

L’IA generativa verrà utilizzata oltre il modello del linguaggio di grandi dimensioni per costruire molti tipi di modelli e il metodo diventerà sempre più multimodale e arcano. Modificherà molti campi dell’attività umana, ad esempio l’istruzione e la biologia. Diversi modelli varieranno nei loro punti di forza e di debolezza. Le loro capacità, dallo scrivere barzellette e disegnare dipinti alla progettazione di anticorpi, probabilmente continueranno a sorprenderci. Proprio come il grande modello linguistico ha sviluppato un modello di linguaggio umano più ricco di quanto previsto dai suoi creatori, è probabile che le IA generative in molti campi apprendano più di quanto implicano i compiti loro assegnati. Le scoperte nei problemi scientifici tradizionali sono diventate probabili.

L’importanza a lungo termine dell’IA generativa trascende le implicazioni commerciali o anche le scoperte scientifiche non commerciali. Non sta solo generando risposte; sta generando domande filosoficamente profonde. Infonderà diplomazia e strategia di sicurezza. Eppure nessuno dei creatori di questa tecnologia sta affrontando i problemi che essa stessa creerà. Né il governo degli Stati Uniti ha affrontato i cambiamenti e le trasformazioni fondamentali che si profilano.

L’apparente perfezione delle risposte del modello produrrà un’eccessiva fiducia nei suoi risultati. Questo è già un problema, noto come “pregiudizio dell’automazione”, con programmi per computer molto meno sofisticati. È probabile che l’effetto sia particolarmente forte quando l’intelligenza artificiale genera un testo dal suono autorevole. È probabile che ChatGPT rafforzi le predisposizioni esistenti verso la dipendenza da sistemi automatizzati riducendo l’elemento umano.

La mancanza di citazioni nelle risposte di ChatGPT rende difficile distinguere la verità dalla disinformazione. Sappiamo già che gli attori malintenzionati stanno iniettando risme di “fatti” fabbricati e immagini e video deepfake sempre più convincenti, in Internet, vale a dire, nel set di apprendimento presente e futuro di ChatGPT. Poiché ChatGPT è progettato per rispondere a domande, a volte inventa fatti per fornire una risposta apparentemente coerente. Quel fenomeno è noto tra i ricercatori di intelligenza artificiale come “allucinazione” o “pappagallo stocastico”, in cui un’intelligenza artificiale mette insieme frasi che sembrano reali a un lettore umano ma non hanno alcun fondamento nei fatti. Resta da scoprire cosa scatena questi errori e come controllarli.

Abbiamo chiesto a ChatGPT di fornire “sei riferimenti sui pensieri di Henry Kissinger sulla tecnologia”. Ha generato un elenco di articoli presumibilmente del signor Kissinger. Tutti erano argomenti e sbocchi plausibili, e uno era un vero titolo (anche se la sua data era sbagliata). Il resto erano invenzioni convincenti. Forse i cosiddetti titoli appaiono come frasi isolate nella vastità dei “fatti” di GPT, che non siamo ancora in grado di scoprire.

ChatGPT non ha una personalità immediatamente evidente, anche se gli utenti lo hanno occasionalmente spinto ad agire come il suo gemello malvagio. La mancanza di un autore identificabile di ChatGPT rende più difficile per gli esseri umani intuirne le inclinazioni piuttosto che giudicare il punto di vista politico o sociale di un essere umano. Tuttavia, poiché il design della macchina e le domande che le vengono poste hanno generalmente un’origine umana, saremo predisposti a immaginare un ragionamento simile a quello umano. In realtà, l’intelligenza artificiale si sta impegnando in un analogo disumano alla cognizione. Sebbene percepiamo l’IA generativa in termini umani, i suoi errori non sono gli errori di un essere umano; commette gli errori di una diversa forma di intelligenza basata sul riconoscimento di modelli. Gli esseri umani non dovrebbero identificare questi errori come errori. Saremo in grado di riconoscere i suoi pregiudizi e difetti per quello che sono? Possiamo sviluppare una modalità interrogativa in grado di mettere in discussione la veridicità e i limiti delle risposte di un modello, anche quando non conosciamo le risposte in anticipo?

Pertanto, i risultati dell’IA rimangono difficili da spiegare. La verità della scienza dell’Illuminismo era considerata attendibile perché anche ogni fase di processi sperimentali replicabili era testata, quindi attendibile. La verità dell’IA generativa dovrà essere giustificata con metodi completamente diversi e potrebbe non diventare mai altrettanto assoluta. Mentre tentiamo di raggiungere la nostra comprensione fino alla nostra conoscenza, dovremo chiederci continuamente: che cosa circa la macchina non ci è stato ancora rivelato? Quale oscura conoscenza nasconde?

È probabile che il ragionamento dell’IA generativa cambi nel tempo, in una certa misura come parte della formazione del modello. Diventerà una versione accelerata del progresso scientifico tradizionale, aggiungendo adattamenti casuali al processo stesso di scoperta.

La stessa domanda posta a ChatGPT per un periodo di tempo può produrre risposte diverse. Lievi differenze di fraseggio che sembrano poco importanti al primo passaggio possono causare risultati drasticamente diversi se ripetute. Al momento, ChatGPT sta imparando da una base di informazioni che termina in un determinato momento. Presto, i suoi sviluppatori probabilmente gli consentiranno di ricevere nuovi input, consumando infine un afflusso infinito di informazioni in tempo reale. Se gli investimenti continuano a salire, è probabile che il modello venga riqualificato con frequenza crescente. Ciò aumenterà la sua valuta e precisione, ma obbligherà i suoi utenti a consentire un margine in continua espansione per un rapido cambiamento. Imparare dai risultati mutevoli dell’IA generativa, piuttosto che esclusivamente dal testo scritto umano, può distorcere la conoscenza umana convenzionale di oggi.

Anche se i modelli di IA generativa diventassero completamente interpretabili e accurati, porrebbero comunque sfide inerenti alla condotta umana. Gli studenti usano ChatGPT per barare agli esami. L’intelligenza artificiale generativa potrebbe creare pubblicità via e-mail che inondano le caselle di posta e sono indistinguibili dai messaggi di amici personali o conoscenti di lavoro. I video e le pubblicità generati dall’intelligenza artificiale che raffigurano false piattaforme di campagna potrebbero rendere difficile distinguere tra le posizioni politiche. Segnali sofisticati di falsità, comprese le filigrane che indicano la presenza di contenuti generati dall’intelligenza artificiale, che OpenAI sta prendendo in considerazione, potrebbero non essere sufficienti; hanno bisogno di essere sostenuti da un elevato scetticismo umano.

Alcune conseguenze potrebbero essere intrinseche. Nella misura in cui usiamo meno il nostro cervello e di più le nostre macchine, gli esseri umani possono perdere alcune abilità. Le nostre capacità di pensiero critico, scrittura e (nel contesto di programmi di conversione testo-immagine come Dall-E e Stability.AI) possono atrofizzarsi. L’impatto dell’IA generativa sull’istruzione potrebbe manifestarsi nel declino della capacità dei futuri leader di discriminare tra ciò che intuiscono e ciò che assorbono meccanicamente. Oppure potrebbe portare a leader che imparano i loro metodi di negoziazione con le macchine e la loro strategia militare con evoluzioni dell’IA generativa piuttosto che umani ai terminali dei computer.

È importante che gli esseri umani sviluppino la fiducia e la capacità di sfidare i risultati dei sistemi di intelligenza artificiale. I medici temono che i modelli di deep learning utilizzati per valutare l’imaging medico a fini diagnostici, tra le altre attività, possano sostituire la loro funzione. A che punto i medici non si sentiranno più a proprio agio nel mettere in discussione le risposte che il loro software fornisce loro? Man mano che le macchine salgono la scala delle capacità umane, dal riconoscimento di modelli alla sintesi razionale al pensiero multidimensionale, possono iniziare a competere con le funzioni umane nell’amministrazione statale, nella legge e nelle tattiche commerciali. Alla fine, potrebbe emergere qualcosa di simile alla strategia. In che modo gli esseri umani potrebbero interagire con l’IA senza rinunciare a parti essenziali della strategia alle macchine? Con tali cambiamenti, che ne è delle dottrine accettate?

È urgente sviluppare una dialettica sofisticata che consenta alle persone di sfidare l’interattività dell’IA generativa, non solo per giustificare o spiegare le risposte dell’IA, ma anche per interrogarle. Con uno scetticismo concertato, dovremmo imparare a sondare metodicamente l’IA e valutare se e fino a che punto le sue risposte siano degne di fiducia. Ciò richiederà una mitigazione consapevole dei nostri pregiudizi inconsci, un addestramento rigoroso e una pratica abbondante.

La domanda rimane: possiamo imparare, abbastanza velocemente, a sfidare piuttosto che obbedire? O alla fine saremo obbligati a sottometterci? Ciò che consideriamo errori fa parte del progetto deliberato? E se nell’IA emergesse un elemento di cattiveria?

Un altro compito chiave è riflettere su quali questioni devono essere riservate al pensiero umano e quali possono essere arrischiate sui sistemi automatizzati. Eppure, anche con lo sviluppo di un maggiore scetticismo e capacità di interrogatorio, ChatGPT lo dimostra il genio della tecnologia generativa è uscito dalla bottiglia. Dobbiamo essere premurosi in ciò che vi chiediamo.

I computer sono necessari per sfruttare volumi crescenti di dati. Ma i limiti cognitivi possono impedire agli umani di scoprire verità sepolte nelle informazioni del mondo. ChatGPT possiede una capacità di analisi qualitativamente diversa da quella della mente umana. Il futuro implica quindi una collaborazione non solo con un diverso tipo di entità tecnica, ma con un diverso tipo di ragionamento, che può essere razionale senza essere ragionevole, affidabile in un senso ma non in un altro. È probabile che questa stessa dipendenza acceleri una trasformazione nella metacognizione e nell’ermeneutica – la comprensione della comprensione – e nelle percezioni umane del nostro ruolo e della nostra funzione.

I sistemi di apprendimento automatico hanno già superato la conoscenza di qualsiasi essere umano. In casi limitati, hanno superato la conoscenza dell’umanità, trascendendo i limiti di ciò che abbiamo considerato conoscibile. Ciò ha scatenato una rivoluzione nei campi in cui sono state fatte tali scoperte. L’intelligenza artificiale è stata un punto di svolta nel problema centrale della biologia di determinare la struttura delle proteine e in cui i matematici avanzati fanno dimostrazioni, tra molti altri.

Man mano che i modelli passano dal testo generato dall’uomo a input più inclusivi, è probabile che le macchine alterino il tessuto della realtà stessa. La teoria quantistica postula che l’osservazione crei la realtà. Prima della misurazione, nessuno stato è fisso e non si può dire che esista. Se questo è vero, e se anche le osservazioni delle macchine possono fissare la realtà – e dato che le osservazioni dei sistemi di intelligenza artificiale arrivano con una rapidità sovrumana – la velocità dell’evoluzione della definizione della realtà sembra destinata ad accelerare. La dipendenza dalle macchine determinerà e quindi altererà il tessuto della realtà, producendo un nuovo futuro che non comprendiamo ancora e per l’esplorazione e la leadership di cui dobbiamo prepararci.

Usare la nuova forma di intelligenza comporterà un certo grado di accettazione dei suoi effetti sulla nostra percezione di sé, sulla percezione della realtà e sulla realtà stessa. Come definire e determinare questo dovrà essere affrontato in ogni contesto immaginabile. Alcune specialità potrebbero preferire cavarsela solo con la mente dell’uomo, anche se ciò richiederà un grado di abnegazione senza precedenti storici e sarà complicato dalla competitività all’interno e tra le società.

Man mano che la tecnologia diventa più ampiamente compresa, avrà un profondo impatto sulle relazioni internazionali. A meno che la tecnologia per la conoscenza non sia universalmente condivisa, l’imperialismo potrebbe concentrarsi sull’acquisizione e il monopolio dei dati per ottenere gli ultimi progressi nell’IA. I modelli possono produrre risultati diversi a seconda dei dati raccolti. Evoluzioni differenziali delle società possono evolvere sulla base di basi di conoscenza sempre più divergenti e quindi della percezione delle sfide.

Finora la maggior parte delle riflessioni su questi temi ha presupposto la congruenza tra scopi umani e strategie delle macchine. Ma cosa succede se non è così che si svilupperà l’interazione tra l’umanità e l’IA generativa? E se una parte considera dannosi gli scopi dell’altra?

L’arrivo di uno strumento inconoscibile e apparentemente onnisciente, capace di alterare la realtà, può innescare una rinascita della religiosità mistica. Il potenziale dell’obbedienza di gruppo a un’autorità il cui ragionamento è in gran parte inaccessibile ai suoi sudditi è stato visto di tanto in tanto nella storia dell’uomo, forse in modo più drammatico e recente nella sottomissione del XX secolo di intere masse dell’umanità sotto lo slogan delle ideologie su entrambi i lati dello spettro politico. Potrebbe emergere un terzo modo di conoscere il mondo, che non è né la ragione umana né la fede. Cosa diventa la democrazia in un mondo simile?

È probabile che la leadership si concentri nelle mani di poche persone e istituzioni che controllano l’accesso al numero limitato di macchine capaci di sintesi di alta qualità della realtà. A causa dell’enorme costo della loro potenza di elaborazione, le macchine più efficaci all’interno della società possono rimanere nelle mani di un piccolo sottogruppo a livello nazionale e sotto il controllo di poche superpotenze a livello internazionale. Dopo la fase di transizione, i vecchi modelli diventeranno più economici e potrebbe iniziare una diffusione del potere attraverso la società e tra gli stati.

Una leadership morale e strategica rinvigorita sarà essenziale. Senza principi guida, l’umanità corre il rischio del dominio o dell’anarchia, dell’autorità illimitata o della libertà nichilista. La necessità di mettere in relazione i grandi cambiamenti della società con giustificazioni etiche e nuove visioni per il futuro apparirà in una nuova forma. Se le massime espresse da ChatGPT non vengono tradotte in uno sforzo umanamente riconoscibile, l’alienazione della società e persino la rivoluzione potrebbero diventare probabili.

Senza adeguate basi morali e intellettuali, le macchine utilizzate nella governance potrebbero controllare piuttosto che amplificare la nostra umanità e intrappolarci per sempre. In un mondo del genere, l’intelligenza artificiale potrebbe amplificare la libertà umana e trascendere le sfide illimitate.

Ciò impone alcune necessità per dominare il nostro futuro imminente. La fiducia nell’intelligenza artificiale richiede miglioramenti su più livelli di affidabilità: nell’accuratezza e nella sicurezza della macchina, nell’allineamento degli obiettivi dell’IA con gli obiettivi umani e nella responsabilità degli esseri umani che governano la macchina. Ma anche se i sistemi di intelligenza artificiale diventano tecnicamente più affidabili, gli esseri umani dovranno comunque trovare modi nuovi, semplici e accessibili per comprendere e, in modo critico, sfidare le strutture, i processi e i risultati dei sistemi di intelligenza artificiale.

È necessario stabilire parametri per un uso responsabile dell’IA, con variazioni basate sul tipo di tecnologia e sul contesto di implementazione. I modelli linguistici come ChatGPT richiedono limiti alle sue conclusioni. ChatGPT ha bisogno di sapere e trasmettere ciò che non sa e non può trasmettere.

Gli esseri umani dovranno imparare una nuova moderazione. I problemi che poniamo a un sistema di intelligenza artificiale devono essere compresi a un livello responsabile di generalità e conclusione. Saranno necessarie forti norme culturali, piuttosto che l’applicazione legale, per contenere la nostra dipendenza sociale dalle macchine come arbitri della realtà. Riaffermiamo la nostra umanità facendo in modo che le macchine rimangano oggetti.

L’istruzione, in particolare, dovrà adattarsi. Una pedagogia dialettica che utilizza l’IA generativa può consentire un apprendimento più rapido e più individualizzato di quanto sia stato possibile in passato. Gli insegnanti dovrebbero insegnare nuove abilità, comprese modalità responsabili di interlocuzione uomo-macchina. Fondamentalmente, i nostri sistemi educativi e professionali devono preservare una visione degli esseri umani come creature morali, psicologiche e strategiche unicamente capaci di esprimere giudizi olistici.

Le macchine si evolveranno molto più velocemente dei nostri geni, causando dislocazione interna e divergenza internazionale. Dobbiamo rispondere con un’alacrità proporzionata, in particolare in filosofia e concettualismo, a livello nazionale e globale. L’armonizzazione globale dovrà emergere o per percezione o per catastrofe, come predisse Immanuel Kant tre secoli fa.

Dobbiamo includere un avvertimento a questa previsione: cosa succede se questa tecnologia non può essere completamente controllata? E se ci fossero sempre modi per generare falsità, immagini false e video falsi, e le persone non imparerebbero mai a non credere a ciò che vedono e sentono? Agli esseri umani viene insegnato fin dalla nascita a credere a ciò che vediamo e sentiamo, e questo potrebbe non essere più vero a causa dell’IA generativa. Anche se le grandi piattaforme, per consuetudine e regolamento, lavorano duramente per contrassegnare e ordinare i contenuti cattivi, sappiamo che i contenuti una volta visti non possono essere nascosti. La capacità di gestire e controllare completamente i contenuti distribuiti a livello globale è un problema serio e irrisolto.

Le risposte che ChatGPT dà a questi problemi sono evocative solo nel senso che sollevano più domande che conclusioni. Per ora, abbiamo un risultato nuovo e spettacolare che rappresenta una gloria per la mente umana come AI. Non abbiamo ancora sviluppato una destinazione per questo. Quando diventiamo Homo technicus, abbiamo l’imperativo di definire lo scopo della nostra specie. Sta a noi fornire le vere risposte.

Mr. Kissinger è stato segretario di stato, 1973-77, e consigliere per la sicurezza nazionale della Casa Bianca, 1969-75. Mr. Schmidt è stato CEO di Google, 2001-11 e presidente esecutivo di Google e del suo successore, Alphabet Inc., 2011-17. Mr. Huttenlocher è decano dello Schwarzman College of Computing presso il Massachusetts Institute of Technology. Sono autori di “The Age of AI: And Our Human Future”. Gli autori ringraziano Eleanor Runde per la sua ricerca.

Lascia un commento