L’intelligenza artificiale in aiuto delle pubblicazioni scientifiche. In tutto il mondo sono in via di sviluppo strumenti automatici, basati sull’intelligenza artificiale, per aiutare o addirittura sostituire, gli esperti che effettuano la peer review, la revisione tra pari che rappresenta lo standard per la pubblicazione dei risultati scientifici. Ma negli algoritmi sono nascoste alcune insidie, e sono ancora gli esseri umani a decidere.

La maggior parte dei ricercatori ha buone ragioni per lamentarsi della peer review, o revisione tra pari: richiede tempo ed è soggetta a errori, e il carico di lavoro è distribuito in modo non uniforme, se è vero che solo il 20 per cento degli scienziati gestisce gran parte delle revisioni.

La peer review eseguita dall’intelligenza artificiale (IA) promette ora di migliorare il processo, aumentare la qualità degli articoli pubblicati e far risparmiare tempo ai revisori.

Alcuni editori scientifici stanno sperimentando strumenti di intelligenza artificiale che coprono l’intero processo, dalla selezione dei revisori al controllo delle statistiche alla sintesi dei risultati di un articolo.

A giugno, un software chiamato StatReviewer, che controlla che le statistiche e le metodologie dei manoscritti siano validi, è stato adottato da Aries Systems, un sistema di gestione della peer review di proprietà del colosso editoriale Elsevier.

ScholarOne, una piattaforma di peer review utilizzata da molte riviste, sta collaborando con UNSILO di Aarhus, in Danimarca, che usa l’elaborazione del linguaggio naturale e l’apprendimento automatico per analizzare i manoscritti. UNSILO estrae automaticamente i concetti chiave per riassumere ciò di cui tratta l’articolo.

Essenziale, però, è che in tutti i casi il compito di decidere cosa fare di un manoscritto rimane al redattore della rivista a cui viene sottoposto.

“Non sostituisce il giudizio editoriale, ma lo rende più semplice”, afferma David Worlock, consulente editoriale del Regno Unito che ha visto una dimostrazione di UNSILO alla Fiera del Libro di Francoforte il mese scorso.

Chi decide

UNSILO usa l’analisi semantica del testo del manoscritto per estrarre quelle che individua come affermazioni fondamentali.

Questo offre una panoramica migliore di un articolo rispetto alle parole chiave che in genere vengono presentate dagli autori, afferma Neil Christensen, direttore vendite di UNSILO. “Troviamo le frasi importanti in quello che hanno effettivamente scritto”, dice, “invece di prendere solo ciò che è venuto loro in mente cinque minuti prima di inviare l’articolo”.

UNSILO identifica poi quali di quelle frasi chiave hanno più probabilità di essere argomentazioni o scoperte, offrendo ai redattori una sintesi immediata dei risultati di uno studio. Inoltre, evidenzia se le affermazioni sono simili a quelle di articoli pubblicati in precedenza, il che potrebbe servire a rilevare un plagio o semplicemente a collocare il manoscritto nel contesto di un lavoro correlato a una letteratura più ampia.

“Lo strumento non prende decisioni”, afferma Christensen. “Sta solo dicendo: ‘Ecco alcune cose che emergono quando si confronta questo manoscritto con tutto ciò che è stato pubblicato prima. La decisione spetta a te”.

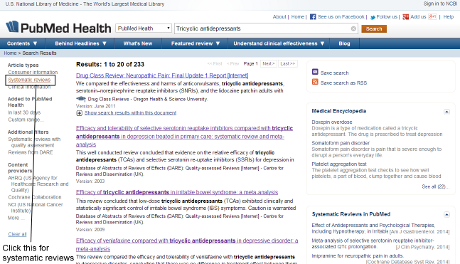

Il prototipo di UNSILO prende informazioni dal database PubMed Central, che gli consente di confrontare i nuovi manoscritti con il testo completo di 1,7 milioni di articoli di ricerca biomedica già pubblicati, un insieme di dati grande ma comunque limitato. L’azienda ha dichiarato che presto aggiungerà oltre 20 milioni di altri articoli da PubMed. La collaborazione con ScholarOne, di proprietà di Clarivate Analytics di Philadelphia, consentirà di accedere a molti altri ancora, compresi quelli del database Web of Science di Clarivate.

Giuliano Maciocci, che guida un gruppo di innovazione presso la rivista “eLife” a Cambridge, nel Regno Unito, afferma che UNSILO è una soluzione interessante per alcuni dei problemi della revisione tra pari, ma non è uno strumento che “eLife” penserebbe di adottare. “Non siamo del tutto convinti che possa essere particolarmente utile nel contesto di una rivista come la nostra, in cui la cura manuale ed esperta è molto importante”, afferma.

Worlock osserva che stanno emergendo diversi strumenti simili. Egli fa parte del consiglio di amministrazione di Wizdom.ai a Londra, una start-up di proprietà degli editori Taylor & Francis, che sta sviluppando software in grado di analizzare database cartacei ed estrapolare connessioni tra discipline e concetti diversi. Questo tipo di strumento, afferma Worlock, sarà utile anche al di là della peer review, per compiti come le domande di finanziamento o le revisioni della letteratura.

Dal plagio ai valori p

Molte piattaforme, tra cui ScholarOne, dispongono già di rilevatori automatici di plagio. E servizi come Penelope.ai esaminano se i riferimenti e la struttura di un manoscritto soddisfano i requisiti di una rivista.

Alcune possono anche segnalare problemi nella qualità di uno studio. Lo strumento Statcheck, sviluppato da Michèle Nuijten, un metodologo dell’Università di Tilburg nei Paesi Bassi e colleghi, valuta la coerenza dei contenuti statistici degli autori, concentrandosi sui valori p. La rivista “Psychological Science” gestisce tutti i suoi articoli con questo strumento, e Nuijten dice che altri editori sono desiderosi di integrarlo nei loro processi di revisione.

Quando il gruppo di Nuijten ha analizzato articoli pubblicati su riviste di psicologia ha scoperto che circa il 50 per cento conteneva almeno un’incoerenza statistica. In un articolo su otto, l’errore era abbastanza serio da cambiare il significato statistico di un risultato pubblicato.

“È preoccupante”, dice. Ma non è una sorpresa che i revisori non vedano quegli errori. “Non tutti hanno il tempo di esaminare tutti i numeri. Ti concentri sui risultati principali o sulla trattazione generale”.

Per ora, Statcheck si limita all’analisi di manoscritti che seguono i criteri dell’American Psychological Association per riportare le statistiche.

Al contrario, i creatori di StatReviewer – Timothy Houle della School of Medicine della Wake Forest University, e Chadwick DeVoss, CEO della start-up tecnologica NEX7 – sostengono che lo strumento può valutare le statistiche in formati standard e stili di presentazione di diverse discipline scientifiche. Per riuscirci, controlla che includano correttamente elementi come le dimensioni del campione, le informazioni sulla procedura in cieco per i soggetti del campione e i dati al basale.

StatReviewer può identificare anche alcuni indizi di comportamenti fraudolenti, afferma DeVoss. “Cose come: ‘hanno giocato con alcune regole statistiche o hanno messo a posto i dati sotto ogni punto di vista’? Se il rischio è più alto di quello che la rivista è abituata a vedere, si possono esaminare i dettagli”.

Algoritmo sotto processo

DeVoss afferma che StatReviewer viene testato da decine di editori. Una prova del 2017 con l’editore open access BioMed Central di Londra è stata inconcludente perché lo strumento non ha analizzato abbastanza manoscritti, ma ha comunque fornito alcune informazioni importanti (BioMed Central sta pianificando un follow-up).

StatReviewer ha evidenziato le lacune dei revisori umani, afferma Amy Bourke-Waite, direttore delle comunicazioni per la ricerca aperta presso Springer Nature, che possiede BioMed Central e pubblica “Nature” (il gruppo che si occupa delle news di “Nature” è editorialmente indipendente da Springer Nature). Per esempio, è stato utile per individuare articoli che non soddisfacevano gli standard richiesti, come seguire CONSORT, un format per manoscritto usato da molti editori.

Bourke-Waite riferisce anche che gli autori che hanno partecipato hanno dichiarato di essere felici di rispondere alle relazioni di StatReviewer quanto lo sarebbero stati di farlo con un revisore umano.

Di tanto in tanto, afferma, StatReviewer ha sbagliato, ma a volte i suoi errori hanno attirato l’attenzione degli autori su cose poco chiare nei loro manoscritti.

I limiti dell’automazione

Anche se le prove avessero successo, DeVoss si aspetta che solo alcune riviste saranno disposte a pagare per fare la scansione di tutti i loro manoscritti. Così, lui e i suoi colleghi si stanno rivolgendo agli autori, sperando che usino lo strumento per controllare i loro manoscritti prima di sottoporli alle riviste.

In generale, nell’uso dell’IA per la peer review ci sono alcune potenziali insidie. Una preoccupazione è che gli strumenti di apprendimento automatico addestrati su articoli pubblicati in precedenza potrebbero rafforzare i bias esistenti nella peer review. “Se costruisci un sistema decisionale basato sugli articoli che la tua rivista ha accettato in passato, avrai dei bias impliciti”, afferma Worlock.

E se un algoritmo fornisce un singolo punteggio complessivo dopo aver valutato un articolo, come fa StatReviewer, i redattori potrebbero essere tentati di non perdere altro tempo e di basarsi semplicemente su quel punteggio per decidere se rifiutare un articolo, spiega DeVoss.

Gli algoritmi non sono ancora abbastanza intelligenti da consentire a un redattore di accettare o rifiutare un articolo unicamente sulla base delle informazioni che estraggono, afferma Andrew Preston, co-fondatore di Publons, una start-up di peer-review-tracking acquistata da Clarivate Analytics, che sta utilizzando l’apprendimento automatico per sviluppare uno strumento che consiglia gli esperti da usare come revisori. “Questi strumenti possono assicurarsi che un manoscritto sia all’altezza, ma non sostituiscono in alcun modo le valutazioni che farebbe un revisore”.

Nuijten è d’accordo: “Ci vorrà un po’ di tempo per perfezionare gli algoritmi, ma vale la pena di automatizzare un sacco di cose perché molti elementi della revisione tra pari sono standardizzati”.

(L’originale di questo articolo è stato pubblicato su “Nature” il 22 novembre 2018. Traduzione ed editing a cura di Le Scienze. Riproduzione autorizzata, tutti i diritti riservati.)

Lascia un commento