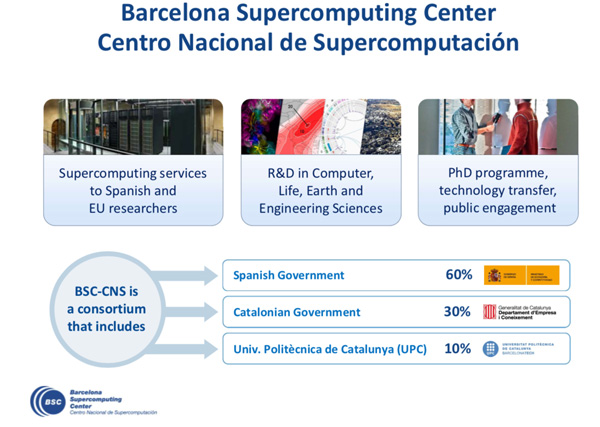

Marenostrum, in una cappella sconsacrata il supercomputer al servizio della scienza. E’ stato insignito del riconoscimento di Più Bel Supercomputer al Mondo nel 2017, ed è uno tra i più potenti supercomputer Europei. Marenostrum si trova a Barcellona e rappresenta un antipasto del futuro. Ricostruita negli anni ’40 dopo la guerra civile spagnola, utilizzata come chiesa Cattolica fino all’inizio degli anni ’60, successivamente sconsacrata per servire ad altri scopi e infine diventare, nel contesto dell’Università politecnica della Catalogna, la casa di uno dei più potenti supercomputer europei e del mondo. Stiamo parlando della Cappella Torre Girona, che dal 2005 accoglie all’interno delle proprie mura MareNostrum: allora con il primato di essere il più potente supercomputer europeo, classificatosi al quinto posto nella Top 500 List del giugno 2005. A gestirlo è il Barcelona Supercomputing Center – Centro National de Supercomputación, consorzio pubblico e prima realtà supercomputing in Spagna e centro di riferimento internazionale. MareNostrum è giunto alla quarta iterazione, dopo il consistente aggiornamento che risale al mese di giugno 2017, quando il sistema è stato espanso nella configurazione ancor oggi operativa. Nello stesso anno è stato insignito del riconoscimento DCD Awards Most Beautiful Datacenter.

A gestirlo è il Barcelona Supercomputing Center – Centro National de Supercomputación, consorzio pubblico e prima realtà supercomputing in Spagna e centro di riferimento internazionale. MareNostrum è giunto alla quarta iterazione, dopo il consistente aggiornamento che risale al mese di giugno 2017, quando il sistema è stato espanso nella configurazione ancor oggi operativa. Nello stesso anno è stato insignito del riconoscimento DCD Awards Most Beautiful Datacenter.

All’interno della Cappella Torre Girona, MareNostrum è installato in una camera di vetro climatizzata ed insonorizzata: stiamo parlando di un supercomputer costituito da 48 rack Lenovo SD530 dedicati alla computazione, ciascuno dei quali composto da 72 nodi Lenovo Stark, da due switch Lenovo G8272, uno switch Intel OPA da 48 porte e quattro unità di alimentazione trifase.

Ogni nodo Lenovo Stark contiene al suo interno due processori Intel Xeon Platinum da 24 core (Skylake a 14 nanometri) e frequenza operativa di 2,1GHz, un quantitativo di memoria variabile (2 GB o 4 GB per core a seconda del tipo di nodo), e una unità SSD Intel S3520. Facciamo un po’ di matematica: ciascun rack ospita ben 3456 core e l’intero supercomputer mette a disposizione quasi 166 mila core, 394TB di memoria RAM e 830TB di storage SSD . Ogni rack è capace di esprimere una potenza computazionale di picco di 226,80 teraflop, per una capacità di calcolo di picco complessiva dell’intero supercomputer di 11,15 petaflop, ovvero oltre 11 milioni di miliardi di calcoli al secondo.

Oltre al blocco di calcolo principale appena descritto, MareNostrum si compone anche di un cluster di tre differenti tecnologie emergenti (con le quali la potenza di picco riesce a spingersi fino 13,7 petaflop), principalmente a scopo sperimentale per valutare e comprendere come aggiungere queste tecnologie nel blocco di calcolo principale. Processori IBM POWER con GPU NVIDIA Volta, processori Intel Knights Hill e processori ARMv8 a 64-bit sono attualmente in uso, rispettivamente, nei tre cluster.

La potenza di calcolo di MareNostrum è interamente al servizio della scienza: il supercomputer del BSC è infatti utilizzato per progetti di ricerca in moltissime discipline scientifiche: astrofisica, medicina, chimica, scienze dei materiali, biologia e molto altro. “L’High Performance Computing è abilitatore per tutti i campi della scienza” osserva Sergi Girona, direttore del BSC. Per entrare nel concreto con un esempio, uno dei progetti di ricerca più recenti portati avanti presso il BSC con l’aiuto di MareNostrum e la collaborazione della stessa Lenovo riguarda la costruzione e l’allenamento di un modello machine-learning capace di identificare eventuali patologie della retina.

Sono molte le patologie che possono dare luogo ad un handicap visivo, ciascuna con caratteristiche, sintomi e cause differenti. I ricercatori hanno sviluppato uno strumento specializzato nell’analisi di dati per elaborare, trasformare e sfruttare le informazioni generate da modelli di machine learning, il tutto appositamente per sfruttare le capacità di MareNostrum 4.

Il problema principale incontrato in questo progetto è rappresentato dalla quantità di informazioni non sufficiente per poter allenare adeguatamente una rete neurale: per quelle patologie dove vi è una limitata disponibilità di dati, per esempio quelle che possono contare su un archivo di meno di 3000 immagini, potrebbe rivelarsi non possibile allenare da zero una rete neurale. Questo problema è stato risolto utilizzando la pratica del “transfer learning”: si vanno a prendere modelli allenati su insiemi di dati più ampi e li si riutilizzano per risolvere quei problemi con una limitata disponibilità di dati.

Il dottor Dario Garcia-Gasulla, postdoctoral researcher per BSC e coordinatore del progetto, spiega: “E’ possibile utilizzare modelli di reti neurali già allenate come punto di partenza per allenare poi modelli più semplici. Invece di costruire e allenare una rete per ogni tipo di patologia della retina, possiamo riutilizzare un modello di base e allenarlo per identificare una seconda patologia, e quindi allenare un altro modello per individuare un’altra patologia e via discorrendo. Questo processo ci consente di realizzare nuovi modelli in maniera molto facile e molto veloce. L’obiettivo del progetto è proprio quello di mostrare quanto facile sia l’impiego di reti neurali pre-allenate: invece di impiegare mesi provando ad utilizzare differenti architetture di rete e configurazioni, possiamo progettare, allenare e validare le prestazioni di un modello di machine learning per rilevare una patologia retinica in meno di 10 minuti sfruttando le CPU o in appena 3 minuti sfruttando le GPU”.

Tenendo conto dei dati che l’Organizzazione Mondiale della Sanità ha a disposizione in questo campo, oggi circa 253 milioni di persone nel mondo vivono con una qualche forma di handicap visivo, ma l’80% dei casi potrebbe essere risolto grazie alla prevenzione e alla diagnosi precoce: prima si identifica il problema, migliori sono gli esiti per il paziente poiché si può andare incontro ad una riduzione fino al 57% del rischio di sviluppare un handicap visivo grave.

“E’ con entusiasmo che abbiamo collaborato con BSC per risolvere un problema impegnativo e con grande impatto umano, sfruttando in particolare le tecniche di transfer learning. Vi sono implicazioni più ampie per quanto riguarda l’adozione dell’intelligenza artificiale in molti settori, non solo quello sanitario. Molte organizzazioni si trovano costantemente ad avere accesso a grandi quantità di dati di qualità e adatti per allenare metodi AI efficaci, dove il transfer learning arriva in soccorso semplificando il lavoro” ha commentato Madhu Matta, Vicepresidente e General Manager High Performance Computing e Artificial Intelligence per Lenovo.

Il progetto di ricerca appena descritto dimostra come la tecnologia e i suoi grandi passi avanti, specie sul terreno dell’intelligenza artificiale, permettano di affrontare e spesso risolvere problemi e sfide che qualche anno fa era impensabile anche solo avvicinare (un ulteriore esempio? L’intelligenza artificiale in aiuto della riabilitazione fisica): è l’incarnazione del concetto di tecnologia come una vera e propria “utility”. Un concetto già elaborato da Andrew Ng, cofondatore di Google Brain e di Coursera, nonché una personalità di rilievo nel mondo dell’intelligenza artificiale, che lo scorso anno arrivò ad affermare che “l’AI è la nuova elettricità”: così come l’elettricità ha trasformato la società, allo stesso modo l’AI ha e avrà un grande potere trasformativo. Trasformazione che non riguarda solamente la ricerca scientifica o accademica (per quanto l’associazione sia automatica quando si parla di High Performance Computing e di intelligenza artificiale) ma attraversa anche aziende e imprese portando così a compimento il vero spirito della “digital transformation”.

Spesso però a livello enterprise le realtà che vogliono imbarcarsi in un progetto AI sono disorientate e poco inclini a compiere investimenti iniziali significativi, preferendo un approccio iterativo per raccogliere i primi successi con i quali giustificare ulteriori investimenti in un secondo momento.

C’è però una buona notizia: il progetto di ricerca condotto presso il BSC esemplifica infatti come l’intelligenza artificiale abbia contribuito a spingere applicazioni cosiddette data-centric in ambito machine learning. E laddove vi sono grossi moli di dati da muovere ed elaborare, sono necessarie prestazioni elevate. Il machine learning, specie nelle fasi di allenamento, si appoggia proprio su tecnologie High Performance Computing e per alcuni aspetti gli ambiti di HPC e di Intelligenza Artificiale vanno sovrapponendosi almeno a livello di carichi di lavoro. Si tratta inoltre di un rapporto sinergico e complementare, poiché in seconda battuta le capacità del machine learning di estrapolare risultati probabili o soluzioni basate su esperienze precedenti permette di eliminare computazioni non necessarie e costose. Già negli scorsi anni si sono affacciati sulla scena tecnologica altri esempi dell’espansione dei casi d’uso dell’High Performance Computing, come ad esempio i Big Data e la loro gestione e analisi. La buona notizia è che quelle realtà che già si sono attrezzate per i Big Data sono già predisposte anche per accogliere l’intelligenza artificiale e il machine learning, e che chi ancora è in ritardo su Big Data e analisi può compiere un investimento in grado di soddisfare allo stesso tempo anche le iniziali esigenze di intelligenza artificiale.

Poco sopra abbiamo fatto cenno a sfide che qualche anno fa era difficile poter immaginare o avvicinare, e verrà naturale chiedersi che cosa ci stia riservando il futuro. La realtà corre sempre più velocemente ed è difficile poter tratteggiare uno scenario, ma un paio di dati possono aiutare ad inquadrare la direzione che sta prendendo l’evoluzione tecnologica. Se adesso si parla di potenze computazionali nell’ordine dei petaflop, il prossimo passo ci porterà alle capacità di elaborazione di classe exascale, la cui disponibilità commerciale potrebbe avvenire nel corso del 2022. Significa un miliardo di miliardi di calcoli al secondo: una capacità che permetterà, per fare un esempio concreto, alle previsioni del tempo di poter elaborare modelli con precisione nell’ordine dei 400 metri quadrati, laddove con le capaità petascale oggi a disposizione si parla di 4 chilometri quadrati.

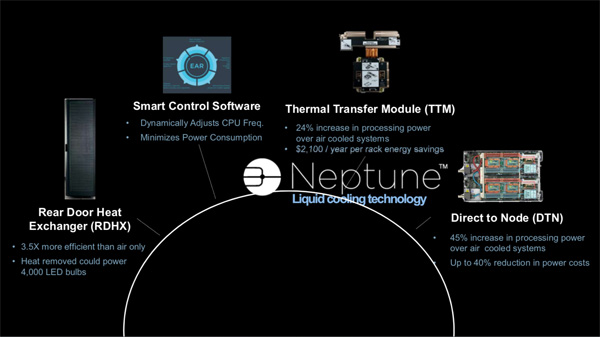

Certo, per arrivare a quel livello di potenza computazionale si passerà obbligatoriamente da un massiccio impiego di GPU e, soprattutto, di sistemi di raffreddamento ad acqua e ibridi: la stessa Lenovo sta inoltre lavorando da tempo ad una tecnologia di raffreddamento che prevede anche l’impiego di acqua non raffreddata se non addirittura “calda” (si parla di temperature attorno ai 50°C ma comunque inferiori a quanto sviluppano le componenti interne di un nodo di calcolo) così che il liquido in uscita possa essere riutilizzato per altri scopi, come ad esempio in un normale impianto di riscaldamento. L’aria infatti non è sufficiente da sola a permettere di mantenere le attuali densità di un datacenter e di rispettare il contenimento dei requisiti energetici.

Il futuro è allora davvero ricco di opportunità, ma come sempre per tutte le grandi innovazioni, e a maggior ragione quelle che possono avere un grande impatto sull’umanità, esiste il rovescio della medaglia rappresentato dai rischi: un interessante spunto di riflessione, proprio a tal proposito, giunge dalle considerazioni della Repubblicana Alexandria Ocasio-Cortez, neo-eletta presso la Camera dei Rappresentanti del Parlamento USA. In occasione delle celebrazioni a New York per il Martin Luther King Jr. Day, l’onorevole Ocasio-Cortez ha sollevato il problema degli algoritmi “discriminatori”, riferendosi in particolare a ciò che può accadere con i sistemi di riconoscimento facciale usati dalle forze dell’ordine. “Gli algoritmi sono creati dagli esseri umani, e questi algoritmi sono ancora legati alle supposizioni di base dell’essere umano. Sono semplicemente supposizioni automatizzate, e se in esse non elimini un eventuale pregiudizio, lo stai semplicemente automatizzando” ha dichiarato Ocasio-Cortez.

Può sembrare una posizione provocatoria, ma è bene ragionare sul fatto che i sistemi machine learning producono output/risultati che riflettono l’allenamento che hanno ricevuto nel corso del tempo. Se le informazioni in ingresso sono in qualche modo condizionate (o è condizionato il modo in cui le informazioni devono essere elaborate) lo stesso accadrà anche per i risultati in uscita. E questi condizionamenti possono essere presenti in maniera non intenzionale e riflettere i condizionamenti sociologici che ruotano attorno a questioni razziali, di genere e di classe sociale. Non v’è da escludere nemmeno la possibilità dolosa, qualora qualche malintenzionato decida di allenare sistemi machine learning intenzionalmente con dati viziati. Un problema che può avere risvolti pratici, ma soprattutto etici, non indifferenti.

L’intelligenza artificiale è uno strumento, come tale non va mitizzata o demonizzata: essa cova l’enorme potenziale di diventare un complemento alle abilità umane, ma anche ai suoi errori. Il limite è molto sottile.

Lascia un commento