Quanto è facile imbrogliare l’intelligenza artificiale? Sciatori per cani, fucili per tartarughe e scarabocchi per stelle marine: ecco come imbrogliare i software di riconoscimento delle immagini.

Chi ha detto che l’intelligenza artificiale è infallibile? Un team di ricercatori del Massachusetts Institutes of Technology (MIT) ha messo a punto un software capace di ingannare i sistemi di riconoscimento delle immagini di Google e fargli credere, per esempio, che la foto di un cane sia in realtà quella di… una coppia di sciatori.

Google sotto scacco. Anish Athalye e il suo team hanno sfruttato una tecnica di attacco informatico nota come adversarial example, il cui meccanismoè tutto sommato semplice: l’immagine originale viene alterata un pixel alla volta e, dopo ogni modifica, sottoposta al sistema di riconoscimento per essere classificata.

Ogni modifica è infinitesimale rispetto alla precedente e quindi il sistema di intelligenza artificiale continua a classificare l’immagine come quella di partenza, anche quando, dopo migliaia di piccole modifiche, il contenuto è completamente diverso.

Basta un puntino. Questa tecnica non è del tutto nuova, ma il software messo a punto del MIT è molto più veloce ed efficace dei precedenti nell’imbastire l’imbroglio.

Tempo fa lo stesso team avevano applicato questo metodo in una situazione reale, facendo credere a un sistema di riconoscimento di immagini che una tartaruga stampata in 3D (e modificata poco alla volta) fosse in realtà un fucile.

Sembra perciò che ingannare un sistema di AI non sia poi troppo difficile, a patto di sapere creare le immagini giuste: Jeff Clune (Wayoming University) ha realizzato un disegno che tutti i sistemi di AI ai quali è stato sottoposto hanno classificato come stella marina. Peccato che agli occhi di un umano non fosse altro che uno scarabocchio.

Gli esperti di OpenAi, organizzazione non profit fondata da Elon Musk, che fa ricerca sull’intelligenza artificiale, spiegano come sia possibile imbrogliare un sistema di riconoscimento di immagini semplicemente aggiungendo alcuni pixel all’immagine di partenza. All’occhio umano la foto rimane praticamente inalterata, ma queste piccole modifiche sono sufficienti per mandare in crisi i più evoluti cervelloni artificiali.

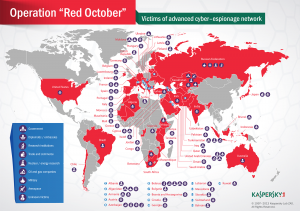

I rischi per la sicurezza. Il perché di questo comportamento delle reti neurali non è ancora del tutto chiaro, ma la facilità con cui è possibile ingannarle può creare non pochi problemi. Per esempio, che cosa potrebbe succedere se una vettura senza conducente non classificasse correttamente un pedone in mezzo alla strada, o se una telecamera di sicurezza non riconoscesse come tale una pistola impugnata da un malvivente?

In realtà, spiegano gli esperti di sicurezza informatica, condurre un attacco di tipo adversarial example non è poi così semplice: occorre infatti inviare al sistema di riconoscimento delle immagini un enorme numero di richieste, in rapida successione, tante quante sono i pixel modificati, cioè milioni. Potrebbe quindi essere abbastanza semplice bloccare l’attacco con strumenti analoghi a quelli usati per bloccare altre forme di hacking. Una possibilità comunque ancora tutta da dimostrare.

Lascia un commento